近日,AI分析师Dwarkesh Patel在其SubStack账号上发表了一篇题为《Thoughts On the AI buildout》的文章,作者包括Dwarkesh Patel和另一位AI分析师Romeo Dean。

这篇分析文章背后也反映了资本市场对当下AI算力和基础设施建设巨额投入所产生的AI投资泡沫的担忧。「明亮公司」此前也曾提及,担忧的一个原因是,今年AI数据中心的投资规模在4000亿美元上下,但AI产生的营收仅约600亿美元——投资和收入差距过大。

但在这篇分析中,Patel和Dean更关注数据中心建设的具体细节和财务数字,他们首先引用了之前Sam Altman在9月23日博客中的一个愿景:“希望创建一个每周能生产一吉瓦(GW)新增 AI 基础设施的工厂“。

Sam Altman在博客中还说:“实现这一愿景将极其困难,我们需要数年时间才能达到这个里程碑,并且它需要在技术栈的每一个层面进行创新,从芯片到电力,再到建筑和机器人技术。但我们一直为此不懈努力,并相信这是可能实现的。在我们看来,这将是有史以来最酷、最重要的基础设施项目。”

Patel和Dean认为,真正决定数据中心建造价值的可能不仅仅是其所反映出的芯片和算力(占总投入的60-70%),而且更要看整个建设的速度。这背后的原因是,GPU技术的快速迭代导致其折旧周期大约仅有3年,而数据中心整个建筑的折旧周期是十几甚至二十年,如果晚交付一个月导致的GPU闲置,就意味着巨大的折旧成本。

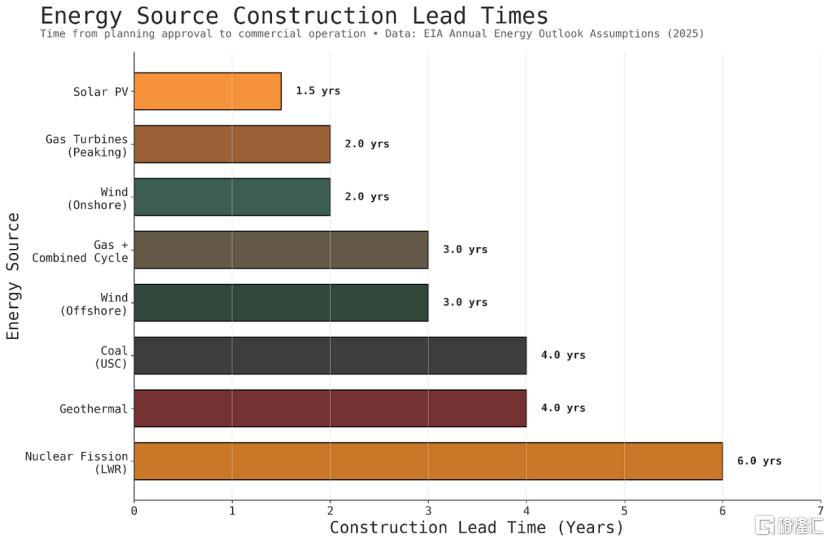

因此,看起来运营成本较低的能源(比如核电),因为其较长的交付周期,实际上成本并不算低;反而是烧天然气的燃气轮机因其较灵活的部署,进而有更好的效果。这也反映了为何GE、西门子能源、三菱等燃气轮机厂商也在近期获得了更多投资者的关注和更好的资本市场表现。

除了能源之外,Patel和Dean指出,目前美国的建设工程人才也存在瓶颈——整个数据中心的设备如果要大规模、快速地交付,需要大量机械工程师等方面的人才,美国“去工业化”后实际上并不具备这种条件。

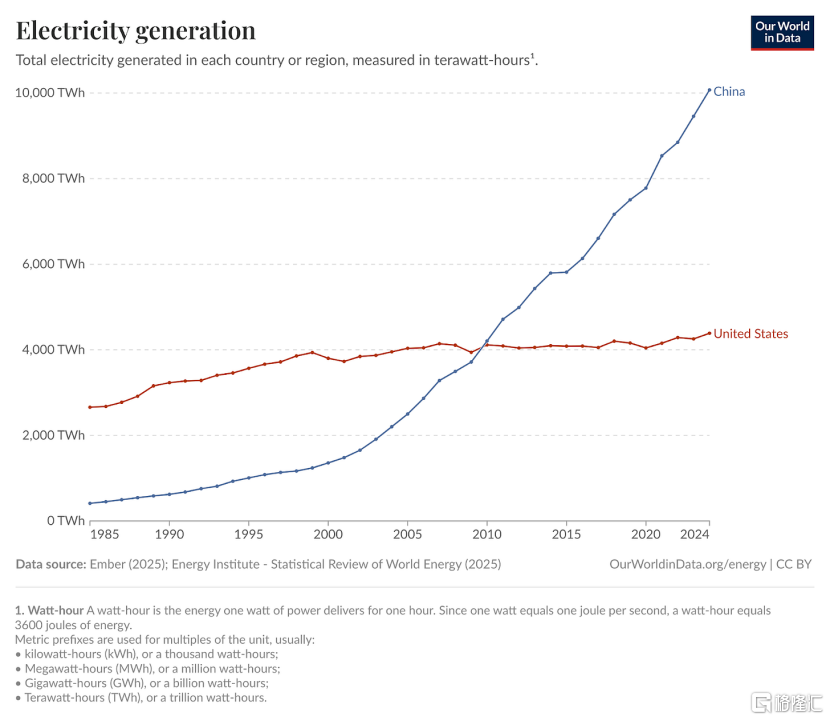

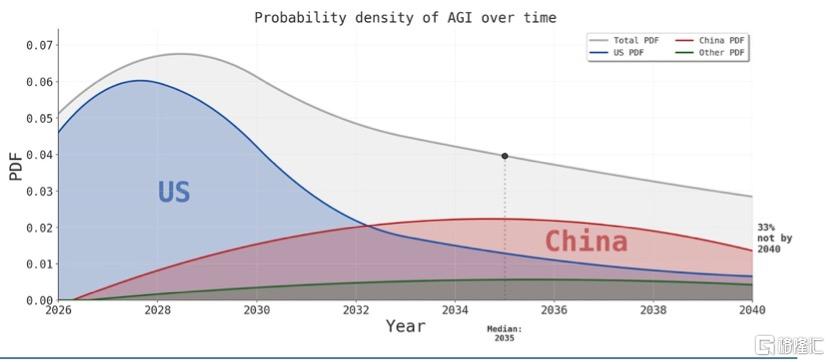

在此基础上,Patel和Dean还讨论了中国在整个数据中心算力基础设施上的优势,包括在电网、能源、建设建造工程人才方面的优势,以及对标台积电、AMSL等核心设备的企业追赶速度,长期来看可能“会默认中国是赢家”。

以下为「明亮公司」编译的内容(有删节):

Sam Altman表示,他希望“创建一个每周能生产一吉瓦(GW)新增AI基础设施的工厂”。

要实现这一愿景需要什么?这在物理上是否可行?这对不同的能源来源、从晶圆厂到燃气轮机工厂等所有上游领域的资本支出(CapEx),以及对中美竞争意味着什么?

这些都不是简单能回答的问题。我们写这篇博客文章是为了加深对这些问题的理解。我们对自己了解到的一些东西感到惊讶。

#1 晶圆厂资本支出的剩余

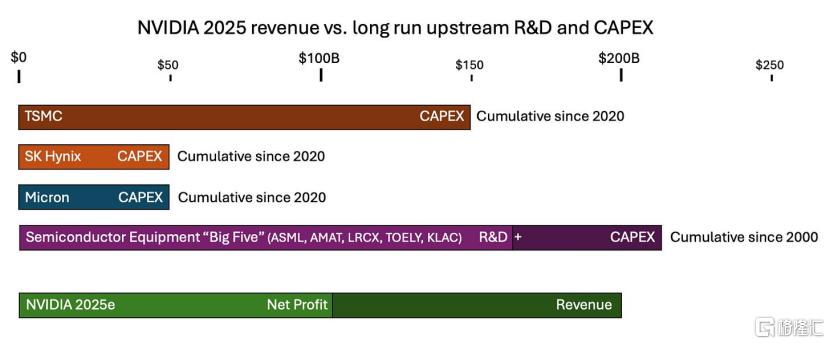

仅凭2025年一年的盈利,英伟达就能覆盖台积电过去3年的全部资本支出。

台积电在过去5年的总资本支出为1500亿美元。这些资金用于许多方面,包括建设整个5纳米和3纳米节点(分别于2020年和2022年推出),以及英伟达现在用于制造数据中心芯片的先进封装技术。仅凭台积电20%的产能,英伟达就创造了1000亿美元的盈利。

假设台积电的节点在5年内折旧——这是一个极其保守的估计(新建的先进晶圆厂的盈利周期超过5年)。这意味着,在2025年,英伟达将把约60亿美元的台积电折旧资本价值,转化为2000亿美元的收入。

再往供应链上游看,英伟达一年的收入几乎与包括ASML、Applied Materials、Tokyo Electron在内的五家最大半导体设备公司过去25年的研发和资本支出总和相当。

我们认为这种情况最适合描述为“晶圆厂资本支出富余”。

我们之所以强调这一点,是因为如果你天真地猜测什么会是第一个限制长期AI资本支出增长的上游环节,你不会想到铜线或变压器——你会从人类有史以来制造的最复杂的东西开始,也就是制造半导体的晶圆厂。我们惊讶地发现,建造这些晶圆厂的成本与人们已经愿意为AI硬件支付的价格相比,简直是小巫见大巫!

如果英伟达愿意,他们甚至可以补贴全新的晶圆厂节点。我们不认为他们会直接这样做(或者他们会吗?想想和英特尔的交易),但这显示了“晶圆厂资本支出”有多么富余。

#2 数据中心上游供应商将不得不扩大生产

在过去的二十年里,数据中心的建设基本上是利用了美国去工业化后遗留下的电力基础设施。我们访谈的一位业内人士说,直到最近,几乎每个数据中心背后都有一个故事。谷歌第一个运营的数据中心就建在一个前铝厂的对面。这些超大规模数据中心运营商习惯于改造旧钢厂和汽车厂的电力设备。

一旦某个行业变得更具现实意义,美国就能迅速而高效地利用前一个行业的“躯壳”。但现在我们进入了一个不同的阶段。超大规模数据中心运营商不仅在以前所未有的更大规模建设新的数据中心,而且是从零开始建设,并相互争夺相同的资源——其中之一就是熟练劳动力。

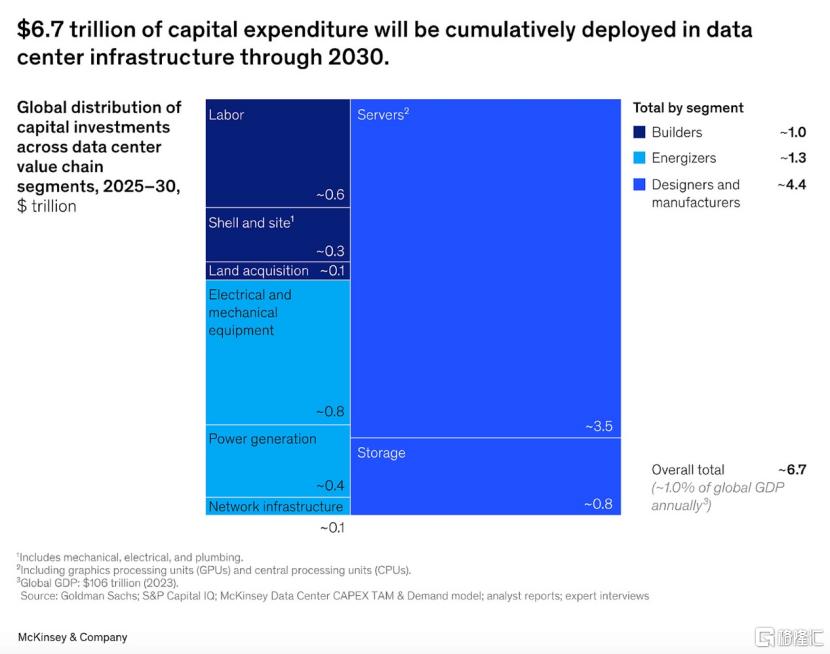

即使是麦肯锡也认为这些资本支出数字并非天方夜谭(到2030年累计6.7万亿美元的资本支出意味着2030年当年约为2万亿美元)。

要让你每年部署2万亿美元的AI资本支出,就必须有其他人在生产价值2万亿美元的所有其他数据中心组件,而不仅仅是芯片。数据中心的上游供应商——那些生产从铜线到涡轮机、变压器和开关设备等一切的公司——将需要建造更多的工厂。

问题在于,这些工厂的成本必须在几十年的生命周期内摊销。按照通常的利润率,只有当这种AI需求能持续10-30年时,这些工厂才值得建造。

建造这些工厂的公司并非对通用人工智能(AGI)深信不疑——它们是经营了几十年的工业企业,利润率低,并且曾被多次需求波动所伤害。在21世纪初,电力需求似乎将要爆炸式增长,因此像通用电气(GE)、西门子等燃气轮机制造商大规模扩张了生产能力。然后需求崩溃,给他们留下了巨大的(几乎导致破产的)过剩产能。

如果不仅晶圆厂存在资本富余,其他数据中心组件也存在,那么超大规模数据中心运营商能否简单地支付更高的利润率来加速产能扩张?特别是考虑到芯片目前占数据中心资本支出的60-70%,这些巨头或许会告诉那些建造另外30%组件的公司不要担心长期需求:“我们只需几年的超高利润率就能让你们回本。”

最大的燃气轮机制造商(GE Vernova、西门子能源和三菱电机)预计在未来5年内从燃气轮机中获利1000亿美元。这对应约100吉瓦的发电能力。这些公司所有部门的合计资本支出约为每年50亿美元。

如果超大规模数据中心运营商愿意为这100吉瓦的发电能力支付2000亿美元而不是1000亿美元(例如,为了激励更快的交付),他们实际上将覆盖这些涡轮机制造商(按当前速度计算)整整20年的全部资本支出。

要建造100吉瓦的数据中心,超大规模数据中心运营商无论如何都需要投资数万亿美元。发电成本仅占数据中心成本的7%左右。如果天然气最终成为最快扩大发电能力的方式,那么为了确保电力能尽快上线,将发电成本翻倍至14%可能是非常值得的。

我们认为,对于数据中心的大多数组件,类似的情况可能都成立。不要低估供给的弹性。

#3 即将到来的劳动力瓶颈?

劳动力实际上可能成为最严重的短缺——我们不能简单地像盖章一样凭空制造出更多工人(至少现在还不能)。

位于阿比林的1.2吉瓦Stargate数据中心设施拥有超过5000名员工。当然,随着我们扩大规模,效率会提高,但粗略计算,要建设100吉瓦,似乎需要417,000人。而这还只是2030年AI电力消耗预测的低端。我们将需要体育场那么多的电工、重型设备操作员、钢铁工人、暖通空调技术员……等等。

作为参考,美国有80万电工和800万建筑工人。我们听说这个劳动力群体正在迅速老龄化,但至少在未来几年内,通过重新分配和提供高薪应该能够缓解劳动力瓶颈。

#4 到2020年代末,4000亿美元以上的ARR是能实现的

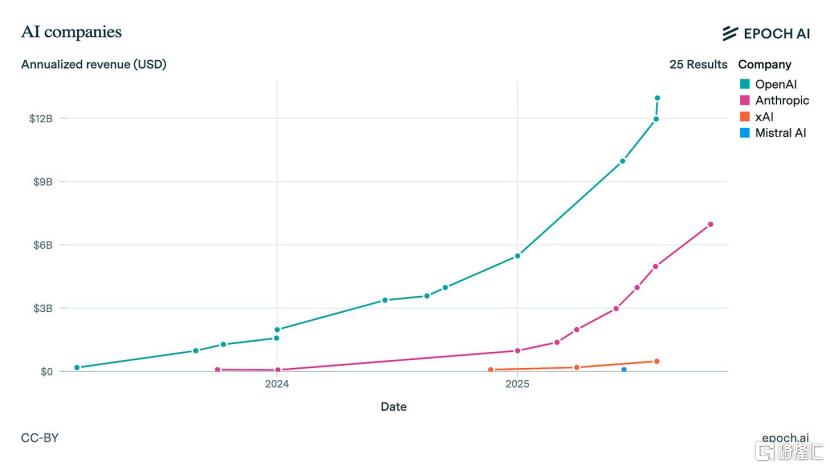

Anthropic和OpenAI每年的AI资本支出(在2025年主要由亚马逊和微软间接完成)似乎在1000亿美元左右。

在过去两年里,OpenAI和Anthropic的收入每年增长三倍。到2025年,它们合计有望实现200亿美元的收入。

这意味着他们在资本支出上的花费是收入的5倍。这种情况可能会随着时间改变——更成熟的行业通常资本支出低于销售额。但AI增长非常快,所以现在投入比赚的多是合理的。

目前,美国的AI资本支出为每年4000亿美元。为了让AI在短期内不成为一个泡沫,目前正在建设的数据中心需要在其生命周期内产生4000亿美元的收入。它们能做到吗?

谷歌、Facebook等公司已经向我们展示,如果你能创造一个对数十亿人有适度用处的产品,你每年就能产生数千亿美元的收入(仅广告一项,谷歌+Meta每年就赚4000亿美元)。

OpenAI正在接近10亿未变现的免费用户,我们认为仅凭其现有产品,收入从120亿美元扩展到1000亿美元是可能的(一个愿景就是:GPT-5为广告变现和超级应用铺平道路)。问题更多在于他们是否能在3-5年内做出一个看起来有前景且经济上有用的GPT-6(或其他产品),从而使他们的收入达到4000亿美元以上的范围。

当然,收入问题最终取决于你的时间线。如果AI真正兑现其承诺,那么它至少可以与白领工资相提并论,后者每年达数十万亿美元。

你认为到2020年代末,AI模型能完成软件工程师的大部分工作吗?如果全球2700万软件工程师都使用每月1000美元的超级AI Agent计划,使他们的生产力翻倍(花费其薪水的10-20%),那将已经是3240亿美元的收入。

#5 交付周期(Lead Times)

建造一个新的吉瓦级以上的数据中心大约需要两年时间——这还不包括调试新一代芯片所需的时间。这意味着,如果你想在2030年部署2万亿美元的资本支出,你需要在2028年就做好规划。按照目前的性能/功耗和性能/价格趋势,2万亿美元大约对应66吉瓦的AI数据中心容量。

在过去几年里,超大规模数据中心运营商和实验室想要的算力总是比他们之前计划开发的要多。如果这些巨头计划未来5年复合年增长率(CAGR)为30%,但最终希望平均达到40%(在2030年达到2万亿美元的资本支出),那么在2030年,他们将需要弥补相对于长期计划的20吉瓦的缺口。

Elon Musk(在他还没有一家AI公司的时候,传统的超大规模数据中心运营商本应预先承诺建设产能)通过做一些疯狂的事情来解决他的限制。普通人是否能在只计划了30或40吉瓦的情况下,造出60吉瓦的全新产能,尚不清楚。

如果AI需求持续超过预先规划,压缩数据中心建设时间线的压力将会巨大。问题是:这对能源来源和数据中心设计意味着什么?一些能源的交付周期比其他能源长得多,而一些数据中心设计更适合快速部署。

在数据中心总拥有成本中,芯片的成本压倒了其他一切。这是因为:一、芯片非常昂贵;二、数据中心的外壳(建筑)可以在12-20年内折旧,而芯片每3年就完全折旧(并且必须更换)。

因此,在选择能源时,你可以非常清楚地看到优先顺序:

1.交付周期-数据中心的外壳晚建成一个月,就意味着占成本绝大部分的芯片闲置一个月。

2.非芯片资本支出-在3年周期内,这比电力运营支出昂贵得多。

3.电力运营支出(OpEx)。

所以你可以理解为什么天然气比目前的核反应堆更受青睐。核电的运营支出极低,但交付周期极长且资本支出高昂。天然气可能不是可再生能源,但你可以在数据中心旁边设置几十台燃气轮机,让你的芯片快速运转起来。

太阳能电池板本身非常便宜,但在平衡夜晚和季节性差异时成本可能很高。如果你完全依赖太阳能,你必须建造大量的过剩容量(考虑到15-25%容量因子,1吉瓦的数据中心需要4-7吉瓦的太阳能容量)并增加大量的电池。否则,你昂贵的芯片在冬天或晚上就有闲置的风险。

太阳能发电场还占用巨大的土地面积,并需要大量的安装劳动力——祝你好运——能雇佣30,000人在沙漠中铺设20,000英亩的太阳能电池板和电池,只为给一个1吉瓦的数据中心供电。目前世界上最大的太阳能园区是中国青海的共和塔拉滩光伏电站。它产生的电力足以为约3吉瓦的平滑连续功率供电——但这需要15吉瓦的峰值容量——意味着720万块太阳能电池板——面积相当于七个曼哈顿。

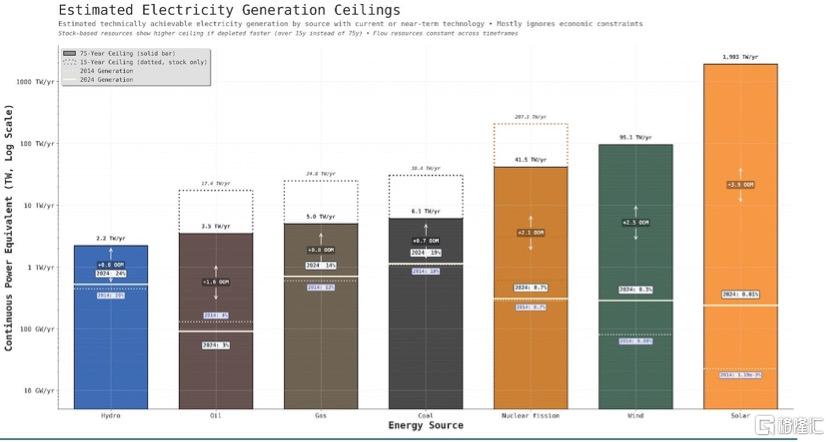

除了交付周期和成本,你可能会问,哪种能源在物理上足够充裕以供应这种需求?答案是,几乎所有能源都够。即使是对于2020年代末最爆炸性的AI场景,所提到的任何能源的理论极限都比需求高出几个数量级。

#6 脱离电网?

一个关键问题是数据中心是否会“脱离电网”——即在现场发电而不是连接到公用电网。一些最大的数据中心已经在这样做了,例如Meta的Orion或xAI的Colossus。

为什么数据中心想要自己发电而不是依赖电网?他们试图绕过并网延迟。现在将大型新电源连接到电网需要超过5年的时间。

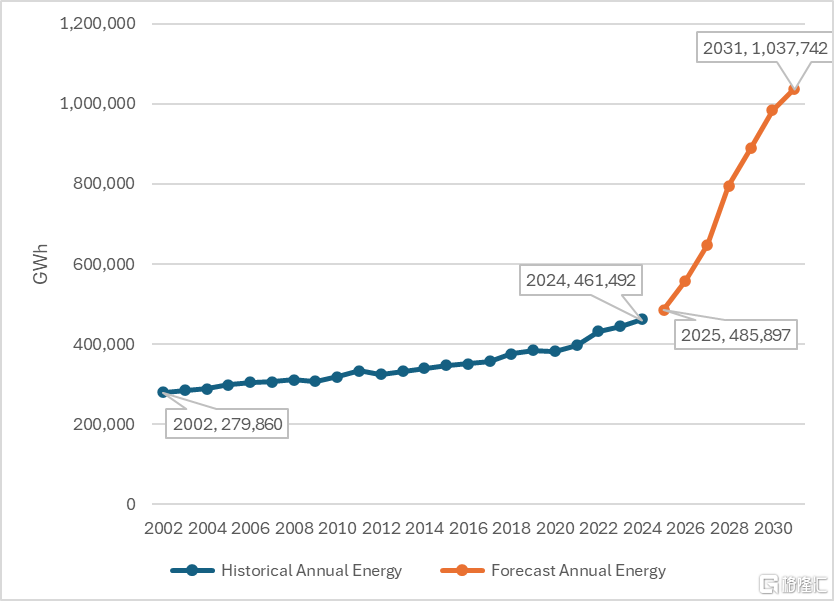

在过去20多年里,美国的电力消耗一直持平或缓慢增长。电网运营商现在预计,由于AI数据中心、制造业回流和电气化同时发生,需求将大幅增加。

ERCOT的年度能源预测。谁能想到他们也对AGI如此深信不疑?

一个潜在的解决方案:杜克大学的一项研究发现,如果数据中心同意在0.25%的时间内(每年约22小时)削减负荷,就可以释放出76吉瓦的备用输电容量。大多数输电线路的平均运行负荷远低于其容量——瓶颈只在需求高峰时出现。

但即使超大规模数据中心运营商能够完美地利用这76吉瓦,在乐观的AI场景下,这也只够用到2026-2028年。之后,要么电网扩张,要么数据中心脱离电网。

#7 数据中心规模的分布

单个数据中心的规模分布会是怎样的?以下是为什么我们最终可能会看到一种遍地都是100兆瓦(MW)数据中心的景象的论点:

如果你可以在这里那里建一个中型数据中心,你就可以吸收电网中的任何多余容量。你可以用一个100兆瓦的数据中心进行这种套利,但在1或10吉瓦的规模上,电网中没有局部的多余容量——那么大的电力本身就相当于一个电网的规模!

对于像预训练这样的学习任务,你需要大块连续的计算资源。但我们已经进入了一个强化学习和中期训练的阶段,学习过程涉及大量推理。而最终的愿景是某种形式的持续学习,即模型广泛部署在经济中,并在工作中/从经验中学习。这似乎与中型数据中心相容,这些数据中心容纳着数以万计的AI实例在工作、创造收入并从部署中学习。

这是另一种愿景。1-10吉瓦的数据中心,然后在设备端进行推理。基本上没有中间地带。

如果我们进入一个垂直整合、工业化生产离网数据中心的世界,也许你想做的就是买一大块地,在现场建一个大工厂,尽可能多地生产独立的计算大厅和电力/冷却/网络模块。当你的公司总共需要50吉瓦时,你不会费心在这里那里为100兆瓦建设定制的基础设施。一个很好的类比是,一个管理着数十亿美元资金的风投不会看任何小于千万美元级别的交易。

#8 一台每周产出一吉瓦的机器

今天的数据中心建设类似于在自家车道上造汽车:引擎从德国运来,变速箱从日本运来,线束从底特律运来,然后一个机械师花几个月在现场组装。每个数据中心都是在1-2年内定制建造的,网络、机电管道系统(MEP)和机架都是一件件组装起来的。

用这种方式,你不可能达到每周一吉瓦的速度。

你能有预制的计算大厅吗?完全布线的机架、冷却系统、电力设备、电池——在工厂里组装好,作为完整的模块运送。这样一来,就不是18个月的现场施工,而是将滑轨模块推入到位。

设计空间出奇地灵活。液冷可以实现500千瓦-1兆瓦的机架,但这需要完全不同的管道和施工。如果太阳能占主导,也许你可以完全采用直流到直流(DC-to-DC)的方式(太阳能板产生直流电,芯片需要直流电),跳过所有的交流转换步骤。每个设计选择都会影响其他选择——能源来源影响冷却方法,冷却方法影响机架密度,机架密度影响建筑设计。

顺便说一句,如果AI最终被证明是一个泡沫,我们离AGI的距离比硅谷想象的要远得多,那么会留下什么持久的价值呢?你可以讲一个故事,说互联网泡沫为互联网后来创造的所有价值铺平了道路。对于这次AI建设热潮,类似的东西是什么?

占资本支出70%的GPU在3年后就一文不值了。建筑物和电力基础设施可以持续几十年,但对于非AI工作负载来说是过度建设的。也许持久的价值是这种新的工业能力:按需快速制造和部署大规模计算基础设施的能力。就像互联网泡沫给我们留下了地下的光纤一样,也许AI泡沫会给我们留下一个工业化的数据中心供应链和一个扩建的电网。

实际上,加密货币为当前的AI浪潮做了这件事。例如,正在帮助OpenAI在阿比林建设Stargate的Crusoe公司,最初就是为了在废弃的天然气上建设比特币挖矿数据中心而成立的。

#9 从长远来看,默认会获胜的是中国吗?

为什么中国不会默认获胜?对于这次工业规模扩张所需的除芯片外的所有组件(太阳能电池板、高压变压器、开关设备、新的电网容量),中国都是全球主导的制造商。中国每年生产1太瓦(TW)的太阳能光伏产品,而美国生产20吉瓦(GW)(即使是这些,电池和晶圆本身也是在中国制造的,只有最终的模块在美国组装)。

中国不仅发电量是美国的两倍多,而且其发电量的增长速度是美国的10倍以上。这一点之所以重要,是因为电力建设可以被导向新的数据中心站点。中国国家电网可以与阿里巴巴、腾讯和百度合作,在对AI建设最有帮助的地方建设产能,避免美国不同超大规模数据中心运营商之间为争夺现有产能而进行的零和博弈。

在长远时间线上,中国是否具有优势?中芯国际可能最终会赶上台积电[也许上海微电子(SMEE)或新凯来(SiCarrier)会赶上阿斯麦,长鑫存储(CXMT)和长江存储(YMTC)会赶上SK海力士和美光,北方华创(NAURA)和中微半导体(AMEC)会赶上Applied Materials, LAM, Tokyo Electron 和 KLA]——出口管制不会永远保持领先优势。如果在2030年之前没有出现纯软件的智能爆炸,而AI只是变成了一场涵盖从机器人到太阳能电池板、电池再到钢铁的整个供应链的大规模工业竞赛,那么为什么最终不是中国领先呢?中国的差异化优势不正是这种快速和大规模的基础设施建设吗?

Semianalysis预测,明年中国实际能够出货的芯片将比今年少,主要是因为国内高带宽内存(HBM)生产的限制。但我们想知道,这在中长期内有多大关系。

GPU在3年内完全折旧(因为新的设计和更好的底层工艺节点使前几代产品变得无关紧要)。而建设新数据中心的交付周期只有一到两年——数据中心的整体设计可能会被重新改造,以适应工业规模的垂直整合。

所有这些都让我们思考,是否每3年,AI竞赛就完全重新开始。虽然我们可能能够限制中国到2028年(甚至可能通过光刻技术的瓶颈限制到本十年末)的生产,但为什么这在2030年之后还重要呢?

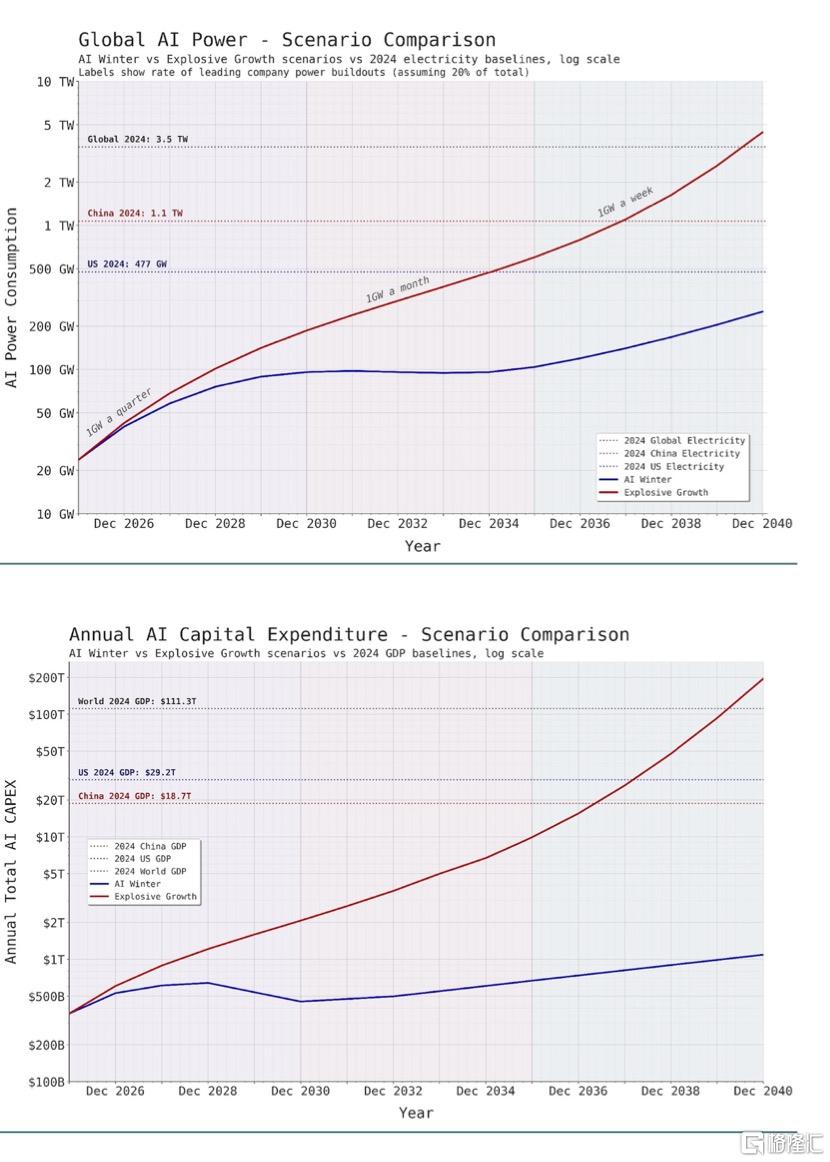

#10 两种情景:AI寒冬和AI爆发

为了理解这类问题,我们认为把数字放入电子表格中非常有帮助。即使情景是凭空捏造的,它们也能让你感觉到,在这些情景成真的世界里,哪些条件必须成立。例如,问这样一个问题很有趣:考虑到硬件价格和性能的趋势,2030年2万亿美元的资本支出将对应多少电力?5000亿美元呢?

我们决定绘制两种不同的潜在轨迹:

1.爆发式增长:AI投资平稳增长,然后在AI自动化带来的蓬勃经济增长(2035年GDP增长30%)的推动下开始加速。

2.AI寒冬:投资增长在2029年左右崩溃,然后从2032年起以平稳的5%年增长率增长。

以下是两种情景下到2040年的AI资本支出和AI电力消耗:

在爆发式增长的情景中,Sam Altman关于领先公司每周1吉瓦的愿景将在2036年实现。但在那个世界里,全球AI的电力消耗将是美国当前发电量的两倍。

作者:MD

出品:明亮公司

下载格隆汇APP

下载格隆汇APP

下载诊股宝App

下载诊股宝App

下载汇路演APP

下载汇路演APP

社区

社区

会员

会员